Você se lembra do que fez em 30 de novembro de 2022? Possivelmente foi um dia como qualquer outro na sua vida e não aconteceu nada de extraordinário que valesse a pena recordar meses depois. O Google não pode dizer o mesmo. Naquele dia, de surpresa e sem aviso, a OpenAI criou algo chamado ChatGPT.

Alguns movimentos empresariais são capazes de gerar terremotos na indústria de tecnologia cujos efeitos podem disparar alarmes na concorrência. E dizemos que podem porque nem sempre acontece (lembre-se da resposta reativa dos líderes de telefonia móvel Nokia e BlackBerry ao surgimento do iPhone em 2007).

Mais do que um “código vermelho” no Google

O lançamento do chatbot de conversação da empresa liderada por Sam Altman provocou mais do que apenas um “código vermelho” no Google. A empresa Mountain View, que atualmente lidera o mercado de pesquisas encontra-se pela primeira vez em anos diante de uma ameaça substancial que a obrigou a tomar medidas drásticas.

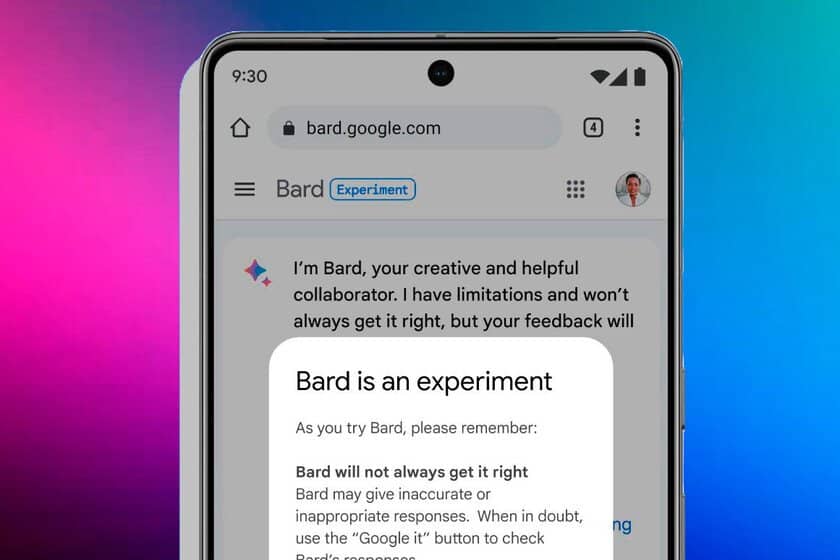

Uma dessas medidas foi o lançamento inicial (de momento apenas disponível em alguns países por convite) do Bard, concorrente direto do ChatGPT e da sua versão melhorada ligada à Internet através do Bing Chat. O problema? Muitos funcionários do Google acreditam que estamos diante de um lançamento muito apressado.

De acordo com informações internas visto pela Bloomberg os liderados por Sundar Pichai tiveram a tarefa de testar o chatbot de inteligência artificial powered by LaMDA (Modelo de Linguagem para Aplicações de Diálogo) antes de sua implantação. A verdade é que muitos dos comentários foram esmagadores, mas a empresa continuou com seu plano de qualquer maneira.

As mensagens negativas entre as equipes do Google não passaram despercebidas. “O Bard é mais do que inútil: por favor, não o libere”, disse um funcionário em fevereiro deste ano, após avaliar a ferramenta. “Ele é um mentiroso patológico”, apontou outro em relação à sua tendência a tentar informações e dar respostas imprecisas.

O clima de tensão e raiva entre alguns funcionários da empresa aumentou após uma série de decisões tomadas pela administração após lançamento do ChatGPT, conforme explicado pela mídia americana acima mencionada. Durante anos, o Google trabalhou no fortalecimento de sua equipe de ética para suas iniciativas de inteligência artificial.

A missão desse grupo de especialistas era ajudar a desenvolver produtos e serviços alinhados aos princípios da empresa, com altos padrões de segurança. Esses tipos de objetivos não apenas exigiam muitos recursos, que o Google concordou em fornecer em 2021, mas também tempo. Este último acabou sendo um inconveniente após a mudança da OpenAI.

Embora a empresa fundada por Larry Page e Sergey Brin não seja inexperiente no campo da inteligência artificial, muitos de seus projetos mais ambiciosos se limitaram a viver dentro do laboratório. Em 2022, o ritmo de desenvolvimento será acelerou consideravelmente deixando certas questões éticas antes elementares em segundo plano.

A dinâmica de trabalho do Google estabelece que, antes de um produto chegar ao mercado, ele deve atingir uma pontuação alta em determinadas categorias. No caso de Bard, isso mudou. “Segurança Infantil”, por exemplo, ainda não chegou a 100 pontos, mas “equidade” pode ser admitida para uma liberação com 80 ou 85 pontos.

As mencionadas, como dizemos, correspondem a informações internas vistas pela Bloomberg. Publicamente, o chefe do Google tem sido otimista com as possibilidades oferecidas por seu chatbot de busca, embora tenha apontado que todos os modelos têm problemas de alucinação e insistiu que a segurança é uma prioridade.